빠른 학습을 위해선 GPU를 사용해야 한다.

서버를 (ex.코랩) 사용하면 더 편리하지만, 오늘은 로컬의 GPU를 사용하려 한다.

그렇기에 cuda 연결을 위해 환경 설정 방법을 작성한다.

1. Nvidia Driver 다운

https://www.nvidia.co.kr/Download/Find.aspx?lang=kr

2. Cuda Toolkit 다운

쿠다를 다운받을것이다.

이때 버전 확인을 잘해줘야 하는데, 이후 3. cudnn을 다운받을 때 Cuda 버전이 호환되도록 다운받는다.

(터미널에서 nvidia-smi를 입력하면 cuda버전이 뜬다. 혹시 몰라 이 버전(11.4) 그대로 다운받으려 한다.)

cudnn 링크

이제 버전 확인을 마쳤으니, 이 사이트에서 맞는 쿠다 버전을 선택하여 다운받는다.

자신의 컴 환경대로 선택하여 설치하면 된다.

[참고] exe(local)과 exe(network)의 차이

local은 대규모 파일이 기본 세팅으로 다운되고,

network는 내가 필요한 파일만 다운받는 것이다.

따라서 local 용량이 훨씬 크다.

여기서 확인 가능하다.

(The Network Installer allows you to download only the files you need. The Local Installer is a stand-alone installer with a large initial download.)

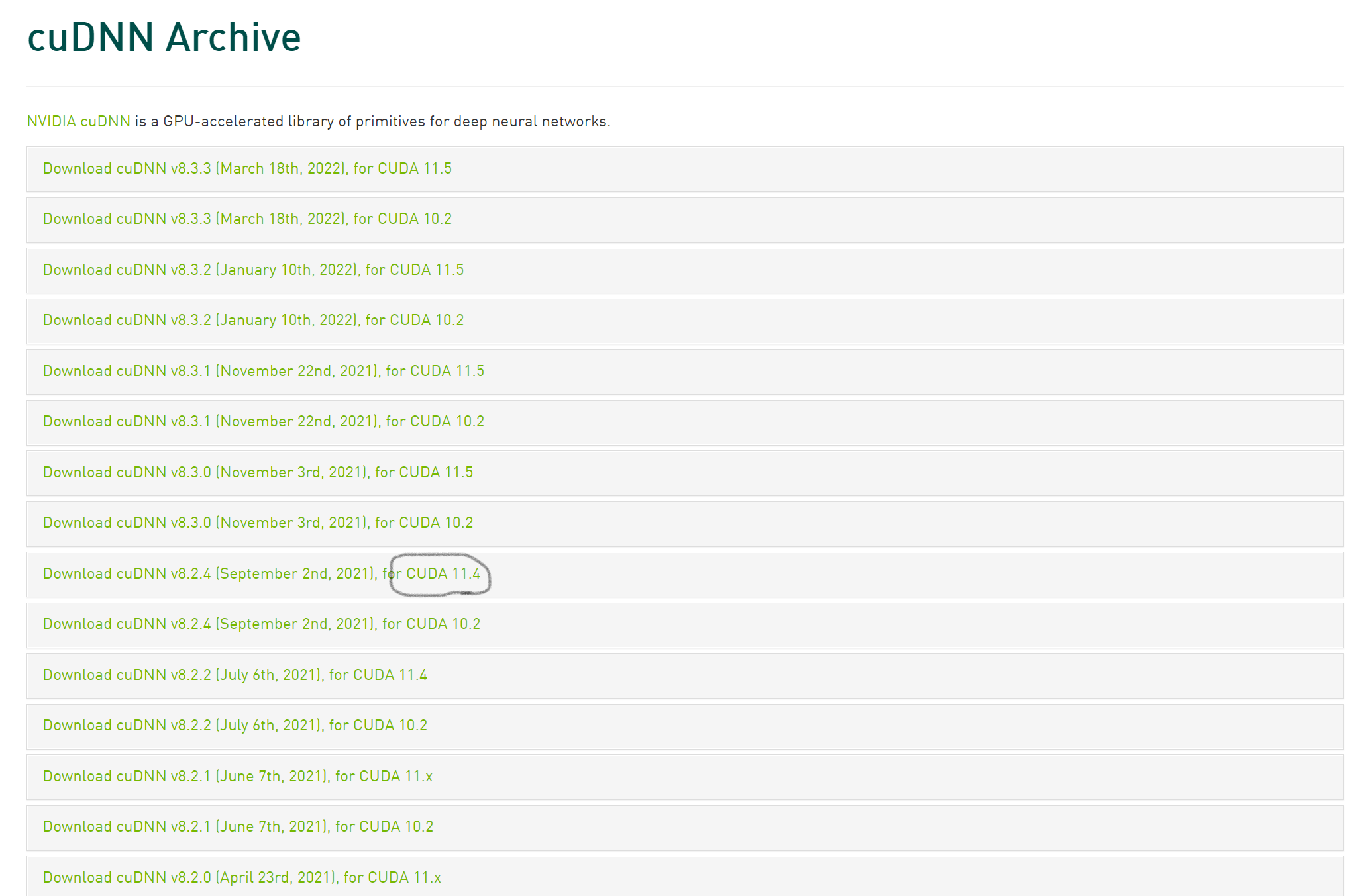

3. Cudnn 다운

위에서 버전 확인 때 등장한 Cudnn 링크에 들어가 이번엔 실제 다운을 받는다. (로그인을 해야한다!)

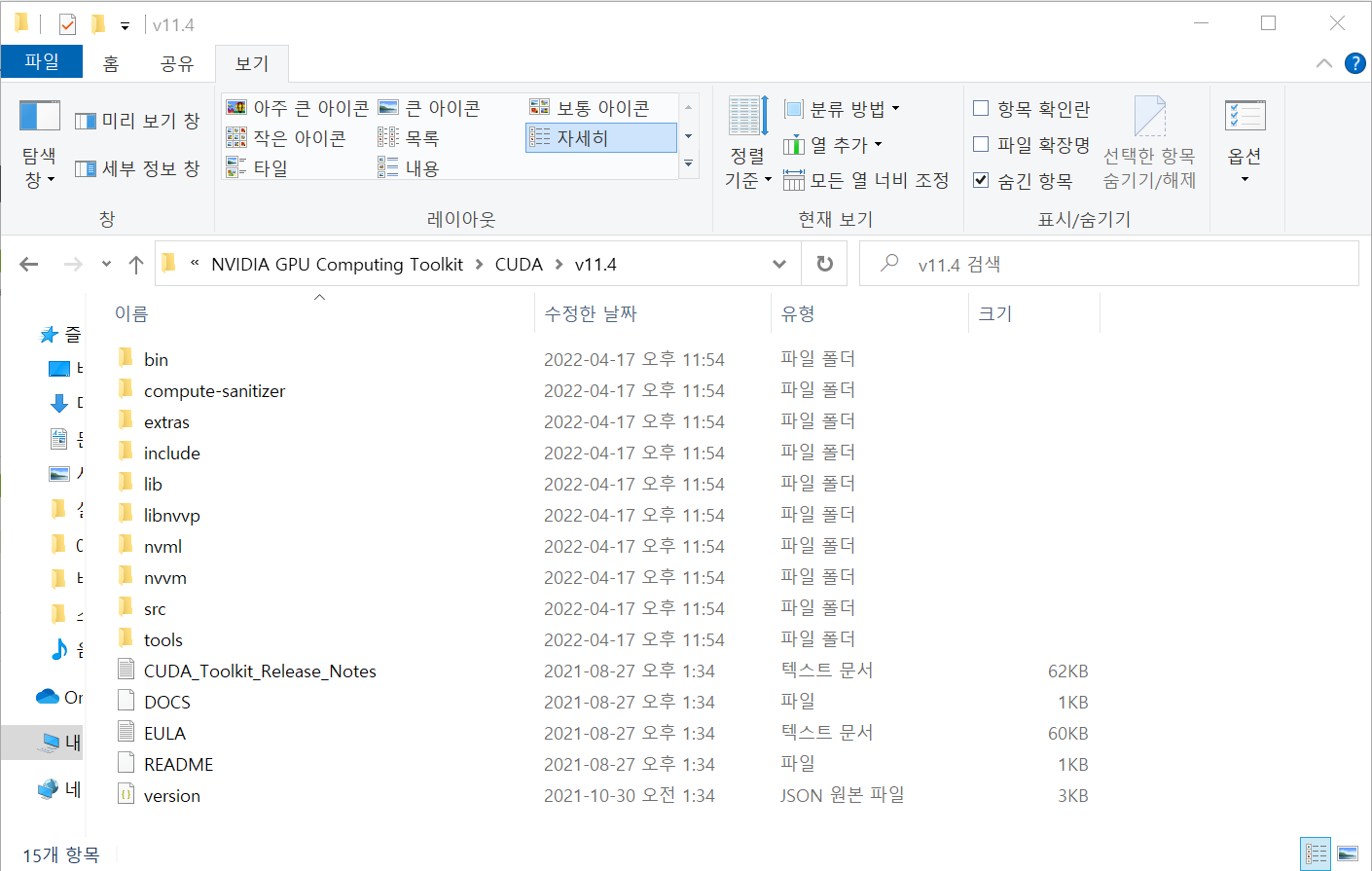

zip 파일의 압축을 푼 뒤, C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v11.4 에

bin, include, lib 파일을 덮어씌워준다.

이후 윈도우의 시스템 환경 변수 편집 에 들어가서 세 폴더의 경로를 추가해준다.

끝! 잘 돌아가나 확인

아래 코드를 실행했을 때 True와 cuda 디바이스가 프린트되면 잘 연결된것이다.

import torch

USE_CUDA = torch.cuda.is_available()

print(USE_CUDA)

device = torch.device('cuda:0' if USE_CUDA else 'cpu')

print('학습을 진행하는 기기:',device)

하지만 난 파이토치를 pip로 설치했지만..

pip3 install torch torchvision torchaudio --extra-index-url https://download.pytorch.org/whl/cu113에러가 난다. 콘다로 가상환경을 만들어 연결해줘야 할 것 같다.

'AI > Tip!' 카테고리의 다른 글

| [데이터 전처리] 학습 전 데이터 처리 (0) | 2021.11.30 |

|---|---|

| [장비] 딥러닝 환경 구축하기 : CPU 환경 (0) | 2021.11.29 |

| [환경] 딥러닝 RAM 부족, 메모리 부족 (0) | 2021.03.12 |

![[환경] CUDA 설치](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Fblog.kakaocdn.net%2Fdna%2FbcXLr8%2FbtrzAWcxCYO%2FAAAAAAAAAAAAAAAAAAAAAEbhUzm1hATK_15OQjBKC0Vq4Un6nu9txeTO-XHUqdHS%2Fimg.png%3Fcredential%3DyqXZFxpELC7KVnFOS48ylbz2pIh7yKj8%26expires%3D1764514799%26allow_ip%3D%26allow_referer%3D%26signature%3Dbi9SLYiK03pC7N58Sv8wyPRJfjM%253D)